- 求职面试导航

- [大数据测试]ETL测试工具和ETL面试常见的问题及答案

- 面试官考的MySQL 原理

- MySQL8.0版本升级建议及各种场景的操作

- 面试遇到不会的问题,该怎么巧妙应对?

- 面试一题:如何通过sql方式将数据库表行转列?

- 搞透这 20 道,SQL面试就没问题了

- SQL面试复习的高级部分

- SQL面试复习-基础部分

- SQL面试复习-高级部分

- docker运行mysql并数据持久化

- 学了半年SQL,她从咨询公司跳槽去当商业分析师

- 【数据分析岗】面试框架梳理

- MYSQL另类利用方式

- SQL练习题和答案(MySQL版)精选

- Mysql和Mongodb面试题

- 在Centos上如何修改密码

- 数分面试中应该知道的5个SQL日期函数

- 外企一道 SQL 面试题,难倒494人!

- mysql 查询优化执行过程

- 网络安全--SQL注入介绍

- 【案例实操】数分面试必知必会的SQL窗口函数

- Mysql之事务篇

- 【案例实操】面试必知必会的SQL窗口函数

- mysql主从切换

- mysql随手记-我没有被面试官“锁”住

- MySQL中MGR中SECONDARY节点磁盘满,导致mysqld进程被OOM Killed

- 测试开发必备:SQL 语法速成手册,yyds!

- 面试无数次总结出MySQL3万字面试题

- mysql命令 详细整理,web开发教学

- MYSQL中锁的各种模式与类型

- MySQL连接控制插件介绍

- SQL笔试题深析

- MySQL 定时备份数据库(基本全)

- 笔试中会碰到书写sql语句的题目(面试题)

- 高频数据库 MySQL 面试题

- 如何解决MySQL数据字典提示1146不存在的问题

- 【数据分析岗】面试高频类型——大数据技能

- MySQL连表查询

- 大厂招聘必问面试题-数据库

- MySQL主从之外,你又多了一项选择,Galera

- SQL测试必备命令和语法教程在这儿!

- mysql死锁查看具体行

- CentOS 7 rpm安装MySQL 5.6

- SQL面试题,快问快答!

- MySql数据库连接超时处理

- 干货!常见的SQL面试题:经典50例!

- 面试打脸TOP 1!简历写精通SQL,你真的是精通吗?

- SQL中的集合

- 可能会遇到的数据库(MySQL)面试题(含答案)

- mysql 左链接 left join 条件写在where 后面与 on后面的区别

- 为何SQL很受名企欢迎?

- mysql插入中文报错的几种解决方法

- MySQL 面试题

- SQL语句中exists和in的区别

- MySQL 高频面试题,最常问!

- MySQL(六)—— 分组函数(多行处理函数)

- Mysql锁机制面试点总结

- MySQL:介于普通读和锁定读的加锁方式(1),MySQL最全整理

- MySQL 高频面试题!

- 面试 (MySQL 索引为啥要选择 B+ 树)

- 设置mysql免密码登录, mysql设置密码

- mysql面试题

- MySQL基础篇之子查询概述

- 记录第一次面试

- MySQL5.7半同步复制

- 面试总结,MySQL 中 int (10) 和 int (11) 到底有什么区别?

- MySQL抓包工具:MySQL Sniffer

- Mysql,我为了面试准备的

- 老板:让你添加一个mysql用户并给予权限这么费劲吗?

- Mysql面试题精选

- MySQL 数据库基础知识点复习

- Java面试,面试题

- 面试官:了解数据库连接池吗?

- MySQL主从复制那些事

- 【Mysql】初识MySQL

- mysql5.7 innodb数据字典

- mysql集群搭建教程-mysql+windows篇

- Mysql数据库导入导出

- 面试题:内存型数据库Redis

- MySQL面试之灵魂拷问

- Mysql数据库日志

- MySQL的底层原理

- MySQL 8.0的新特性-克隆插件

- 面试被问 | 数据库连接池为什么要用threadlocal呢?

- Java面试之MySQL

- 浅谈 MySQL 的临时表和临时文件

- MySQL为什么varchar字段用数字查无法命中索引,而int字段用字符串查却能命中?

- mysql面试之ORM

- MySQL 那些常见的错误设计规范

- 面试超过1000人的资深HR亲诉:如何有效回答数据分析面试问题?

- MySQL 十大常用字符串函数

- 面试必备:聊聊什么是数据库范式?

- 如何将tableau与mysql连接起来

- 如何有效回答数据分析面试问题?

- MySQL一条SQL语句执行过程,讲得通俗易懂!

- BAT数据分析面试过程详解

- MySQL 体系架构简介

- MySQL面试题:数据库读写分离

- MySQL自动删除历史数据

- 数据库面试题-Oracle部分

- Mysql各种锁机制(全面)

- MySQL最新面试题题库

- MySQL replace into行为解析

- 橙心优选-数据仓库高级工程师面试

- MySQL 开源工具集合

- 数据工程师面试常见题目汇总

- MySQL外键约束

- 蚂蚁金服:数据仓库高级工程师面试

- 老板:让你添加一个mysql用户并给予权限这么费劲吗?

- 数据分析岗位跳槽面试需要做什么准备

- 如何查看Mysql执行计划

- MySQL面试:数据库自增 ID 用完了会发生什么?

- linux系统下的MySQL 安装及性能测试

- Mysql高级优化(二)

- MySQL架构设计

- 面试!资深数据分析RoadMap

- max_allowed_packet引起MySQL迁移丢失数据的问题

- 美团面试题:MySql批量插入时,如何不插入重复的数据?

- SQL面试:如何快速定位消耗CPU最高的sql语句

- MySQL性能提升40%的AHI功能,你知道么?

- Mysql高级优化(一)

- 数据科学家V.S数据分析师面试全对比

- sql面试:sql中的行转列和列转行

- MySQL面试-基础篇(一)

- 两道常见的MySQL面试题

- MySQL面试-日志录入格式

- 数据分析师也有帮派!四大门派鼎足,你属于哪一派?

- 产品经理必知必会的SQL

- MySQL数据类型-枚举

- MySQL8.0版本选型建议

- 35张图带你 MySQL 调优

- InnoDB从内分析之Row(一)

- 百万级数据库优化

- 数据库常见面试题(三)-缓存与数据库的一致性

- MySQL面试题:MySQL误删数据怎么办?

- 后台JAVA面试-数据库部分(三)

- 什么职位需要使用 SQL_数据处理领域_详解SQL_SQL与NoSQL_什么是NewSQL 数据库

- 后台JAVA面试-数据库部分(二)

- 后台JAVA面试-数据库部分(一)

- 由一个go中出现的异常引出对php与go中操作sql的一些分析

- MySQL事务处理特性的实现原理

- 数据库面试题目集锦

- 如何解决String.hashCode,移植到mysql中时遇到的int溢出问题

- MySQL锁都分不清,怎么面试进大厂?

- Mysql全局锁和表锁

- Innodb存储引擎

- 数据库常见面试题(二)-MySQL分库分表

- MySQL 使用 SQL 语句快速复制表和数据

- 数据库常见面试题 (一)-索引

- MySQL监控第03期:Zabbix 监控 MySQL

- MySQL 监控 第02期:PMM 监控 MySQL

- MySQL 监控 第01期:Prometheus+Grafana 监控 MySQL

- 数据库层面问题解决思路

- MySQL冷备份过程

- innodb 存储引擎下面的MySQL事务

- 分页场景慢?MySQL的锅!

- Mysql触发器

- MySQL 优化笔记

- MYSQL8初始化设置

- MySQL 的共享锁和排它锁以及自动提交

- Ubuntu安装mysql

- 收集一些MySQL常见用法和技巧

- MySQL 慢查询

- MySQL 判断表和数据库是否存在

- 将纯真 IP 数据库导入 MySQL 数据中

- 如何使用 PHP 以发送邮件的方式自动定时备份 MySQL 数据库表数据

- 解决 Navicat 出错 1130-host . is not allowed to connect to this MySql server

- MySQL 服务器无法存 Emoji 表情的解决方案

- CentOS 6.5 部署 Apache-2.4.10 + PHP-5.6.3 + MySQL-5.1.73 + Magento-1.9.1.0

- MySQL 单机双机主从同步复制备份配置

- node-mysql-promise 基于 Node.js 异步操作 MySQL 数据库组件

- MYSQL 常用命令大全整理

- mysqldump 备份恢复数据库

- 数据库和SQL简介

- Python操作MySQL

- mac 安装mysql_mysql启动数据库命令_MySQL Workbench

- 【后台开发面试题】如何分库分表_什么是分库分表_mysql分库分表 中间件_分表逻辑

- 【数据库 的面试】redis缓存一致性怎么保证?redis mysql 缓存方案_mysql缓存机制_redis同步数据到mysql

- 【数据库 面试题】mysql缓冲池_Buffer Pool_LRU缓存淘汰算法_双向链表和单链表的区别

- 【腾讯面试 mysql题目】数据库面试题_mysql处理能力_连接池配置_数据库面经

- 【数据库查询命令】mysql查询当天、本周、上月的数据

- debian下安装mysql

- 还原工具mysqldump_mysqldump备份多个数据库_执行还原操作_导出表

- Centos7 yum 方式安装 Mysql_centos安装mysql客户端

- docker安装mysql5.7_docker部署mysql_docker创建mysql容器

- 数据库的面试题集_MySQL 面试题_MySQL面试_MySQL 的题集

- MySQL的学习资源:github,官方资料,书籍,大神博客,优秀公众号,学习网站,专栏,文章

- mysql知识:数据库设计,mysql存储引擎,mysql索引优化,mysql错误日志,mysql复制

- 数据库事务总结

【数据分析岗】面试高频类型——大数据技能

之前,出过一篇面试高频类型——数据倾斜该咋办?

招聘热季,最近常有同学问我:

数据分析岗针对大数据技能,

需要掌握不?掌握多少?都考些啥?…

本篇,追根溯源,好好唠个明白。

内含 高频大数据面试真题 。

——正文手动分割线——

分为以下几个方面:

一、啥是大数据技能?

二、为啥有面试官会问这类?

三、是否需要掌握?需要掌握多少?

四、如何复习准备?

五、高频面试题?

一啥是大数据技能?

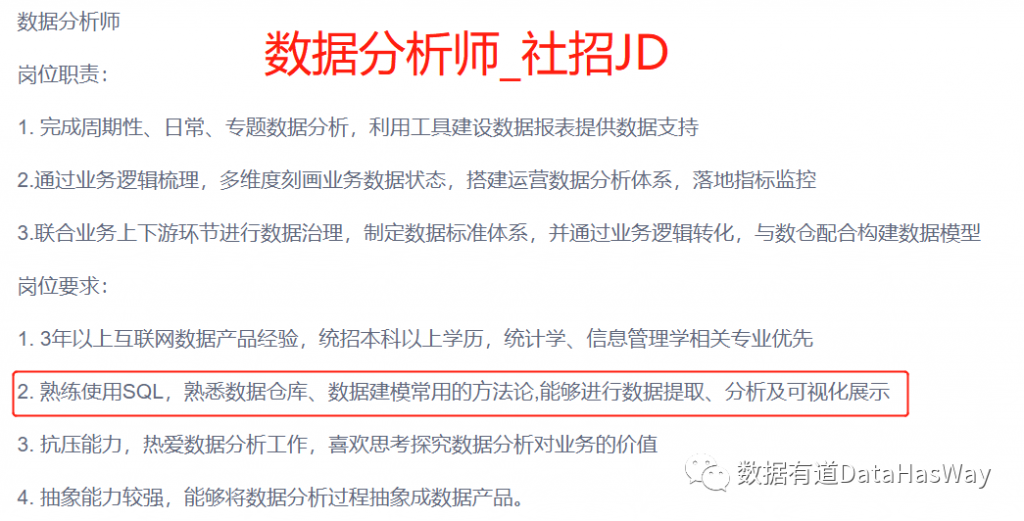

话不多说,直接看图。

部分公司的jd中会写上一句 “有Hadoop开发经验优先”、“有一定HIVE SQL的性能优化经验优先”。

直白总结,数据分析师,顾名思义,与数据有关。因此,和数据分析师有关的大数据技能,即和数据上中下游相关的一些技能。例如:上游的数据日志清洗,中游的数据提取、性能优化,下游的应用层建模等等。

二 为啥会考核?

并不一定是所有公司都会针对此技能考核。取决于公司规模、团队归属部门及职能,以及部分面试官个人喜好。

1、公司规模从职责角度来说,作为数据分析师,天天和数据库打交道。如果了解一些数据库底层原理,对于代码性能调优、日常任务部署优化等具有优势,可相对提高工作效率。

- 大公司:底层数据建设相对完善,不强制要求数据分析师一定需具备数据开发能力,基础数据产品完备,已辅助数据分析师降低日常数据提取的操作成本。

- 中小型公司:绝大多数公司的底层建设相对不太完善,没有操作方便的数据提取工具、没有体验友好的可视化界面、没有自动代码调优的数据产品等等,可能需要数据分析师懂点Linux脚本语言、需要会点数据开发知识。

从成本角度来说,

服务器资源是公司一大笔开销成本。

- 对于大公司,不言而喻,粮草充足,这部分成本完全可以cover住;

- 中小公司,开源节流,每一项开支都要精打细算,耗资占比较高的服务器成本当然也不例外。

所以有些中小型公司要求数据分析师,最好懂得一些数据开发基本原理知识,无论是对于资源的合理使用,还是日常工作的数据提取都有帮助。2、团队部门及职能

Title为 “数据分析工程师” 的一般对大数据技能要求稍高一些,由于工作内容会涉及到偏数据工程部分,因此面试中问到此类知识的概率和密度较高。

Title为 “数据分析师” 的大部分对大数据技能的态度是有则是加分项。

但有些岗位所属部门偏中台,或者归属于ETL的数仓团队,由于所属部门调性,数据分析师可能需要承担部分ETL工作,比如构建公共模型供给各业务支线使用,因此要求懂一些基础的数开知识,方便开展工作。

3、面试官个人喜好

面试中,有可能碰到交叉面,有些面试官并不一定是数据分析出身,会根据他所负责领域、日常工作常见问题进行提问。有可能面试官考核侧重点不同,有些较注重应聘者的基础知识掌握是否扎实,会针对数据分析师的基本功、实践能力进行考核提问。因此,所遇面试官不同,偏好不同,会被问到的大数据相关技能的概率、知识深浅程度不同。

三是否需要掌握?

一方面对照第二部分,尽量获取到你所面试的行业和部门信息,直接看Title、看部门初步判断。另一方面取决于你的准备时间是否充分。由于数据分析师,不仅需要具备业务思维,又需要利用专业知识、从数据角度为业务赋能。

因此涉及知识面广,所需要复习准备的领域较多

详情可参考 【数据分析岗】面试框架梳理(含高频题型)所以,针对应届生:如果你的时间充分,其余方面准备的差不多,在有余力的情况下,多学多准备有益无害;如果你的时间较为紧张,从考核概率和知识点密度角度来说,建议优先准备其他方面。

针对(准)应届生/社招:时间较为充裕,多学习总有好处。

四如何复习准备?

对于时间充裕的,可以阅读相关书籍、去阿里云网站学习操作手册,争取较系统的了解掌握。(ps.公众号资料包里有相关书籍推荐)时间较为紧张的,还是那句话,用“应试”思维,先准备其他方面,学会“搏”考核概率高的知识点。

五高频面试题

问题1:数据倾斜是什么?造成原因有哪些?该怎么办?

思路参考:详见此篇 【数据分析】面试高频类型——大数据技能(一)

问题2:介绍一下Mysql和Hivesql的区别?

思路参考:可以从两方面来回答。

一方面,可以从底层原理出发回答,例如:

- 查询语言不同:Hive是hql语言,Mysql是sql语句;

- 存储位置不同:Hive是建立在 Hadoop 之上的,所有数据存储在hdfs中的,而Mysql数据是存储在自己的本地文件系统中;

- 数据格式:Hive数据格式可以用户自定义,Mysql有自己的系统定义格式;

- 数据更新:由于Hive的设计是针对数据仓库的应用而设计,应用场景读多写少。故Hive中不支持对数据的增改。而Mysql中的数据可支持更新修改;

- 索引:Hive在加载数据的过程中不会对数据进行任何处理,甚至不会对数据进行扫描,因此也没有对数据中的某些 Key 建立索引,在查询数据时是通过Mapreduce很暴力的把数据都查询一遍,因此访问延迟较高。但由于 MapReduce 的引入,Hive 可以并行访问数据,故即使没有索引,对于大数据量的访问,Hive 仍然可以体现出优势。而Mysql有索引,对于少量特定条件的数据的访问,数据库可以有很高的效率,较低的延迟。

- 数据规模:由于 Hive 建立在集群上并可以利用 MapReduce 进行并行计算,因此Hive存储的数据量超级大,而Mysql只是存储一些少量的业务数据;

- 底层执行原理:Hive底层是用的Mapreduce,而Mysql是excutor执行器;

另一方面,也可以从作为使用者角度出发回答,例如:

- Hivesql不支持非等值连接,一般使用left join、right join 或者inner join替代来处理逻辑;

- Hive中不能使用省去join的写法;

- Hive不支持将数据插入现有的表或分区中,仅支持覆盖重写整个表。利用INSERT OVERWRITE 重写覆盖;

- HQL不支持行级别的增、改、删,所有数据在加载时就已经确定,不可更改。

问题3:如果查询一个数据很大很慢,该如何解决?

思路参考:

首先,Hive对SQL语句性能问题排查的方式,有2种:

- 使用explain查看执行计划;

- 查看YARN提供的日志。

常用的优化思路有以下几种:

- SQL语句优化:例如,是否使用了distinct,是否可以加入一些限定条件过滤等;

- 调参优化:例如设置map、reduce的参数;并行执行,调节parallel参数等;

- 数据格式优化:执行同样的SQL语句及同样的数据,只是数据存储格式不同,执行时长也会不同。

- 以空间换时间:例如,有效地减小数据集,拆写逻辑,建立临时表。

问题4:为什么要对数据仓库分层?

思路参考:可以针对数据仓库的使用方分角色来阐述。例如:

- 操作者:数据仓库分层本质是 以空间换时间。通过数据分层管理可以简化数据清洗的过程,相当于把一项复杂的工作拆成了多个简单步骤的工作,从一个大的黑盒变成了一个透明盒,每一层的处理逻辑相对易理解易操作,较易保证每一个步骤的正确性,当数据发生错误的时候,一般不会牵一发而动全身,只需要局部调整某个步骤即可。若不分层,当源业务系统的业务规则发生变化将会影响整个数据清洗过程,工作量巨大,耗时较长。

- 应用者:提升应用系统的用户(比如BI)体验和效率。例如

- 清洗后的脏数据,简化业务复杂结构数据,具有清晰数据结构,减少重复开发;

- 规范的表&段名称,统一的字段数据格式,完善的注释内容,易于定位和理解。

问题5:数仓分层的结构有哪些?每一层的大致作用是什么?

思路参考:常见通用数仓分层设计:ODS、DW、APP。

每层主要作用如下:

- ODS:数据源层。主要将各个业务数据导入到大数据平台,作为业务数据的快照存储。

- DW:汇总数据层。

- DWD:明细数据层。保留数据的原始粒度,在ODS基础上对数据加工处理,提供清洗后较干净的数据。

- DWS:汇总数据层。主题层,根据业务域划分,存放高度聚合汇总的数据。

- APP:面向业务定制的应用数据层。服务于业务特定场景,复用性不强。

以上就是关于大数据技能系列(二)总结。