1 概述

1)应用场景

在本文中,我们会将一个数据库中的数据迁移到另外一个数据库中,并对迁移过去的数据进行聚合处理。

希望用户可以通过这个简单的示例,入门ETL作业功能。

附:FineReport下载地址点击下载个人免费数据分析可视化软件

2)功能简介

当前 ETL 作业 中有三个节点:离线同步、SQL脚本、虚拟节点

3)注意事项

在「ETL作业」中使用到的所有数据连接不要随意改名字,更改名字会导致「ETL作业」中选择的数据连接和数据表丢失。

2 示例

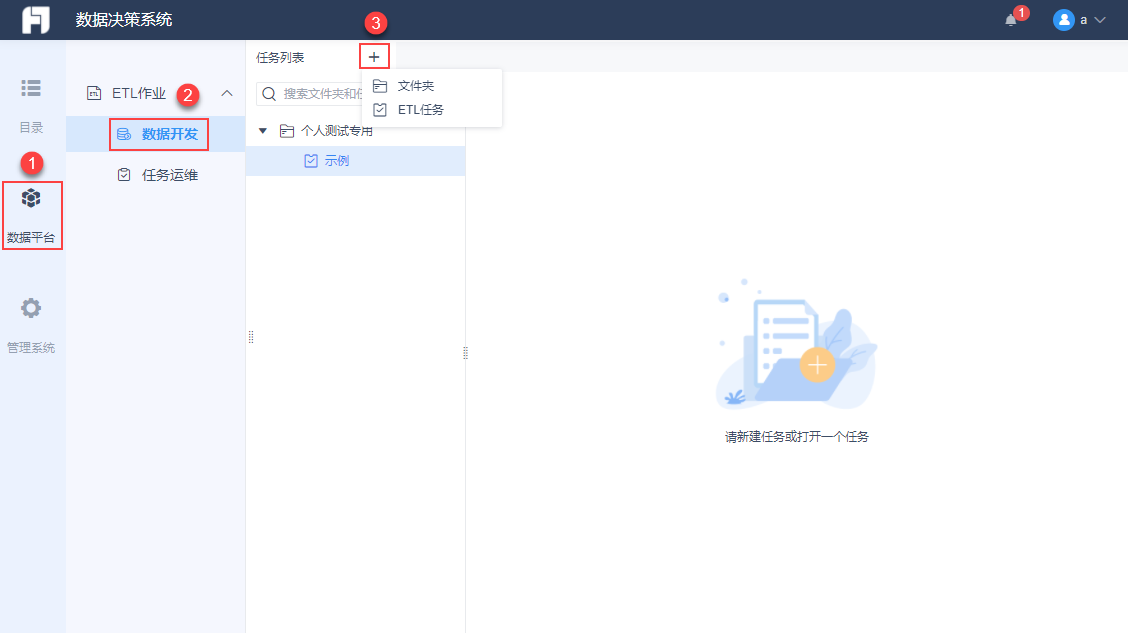

1)创建任务

进入数据平台模块,在「ETL作业>数据开发」中,管理员和拥有任务管理权限的用户可以创建「ETL任务」和「文件夹」。如下图所示:

其中「文件夹」用于存放任务,方便对任务进行分类管理。

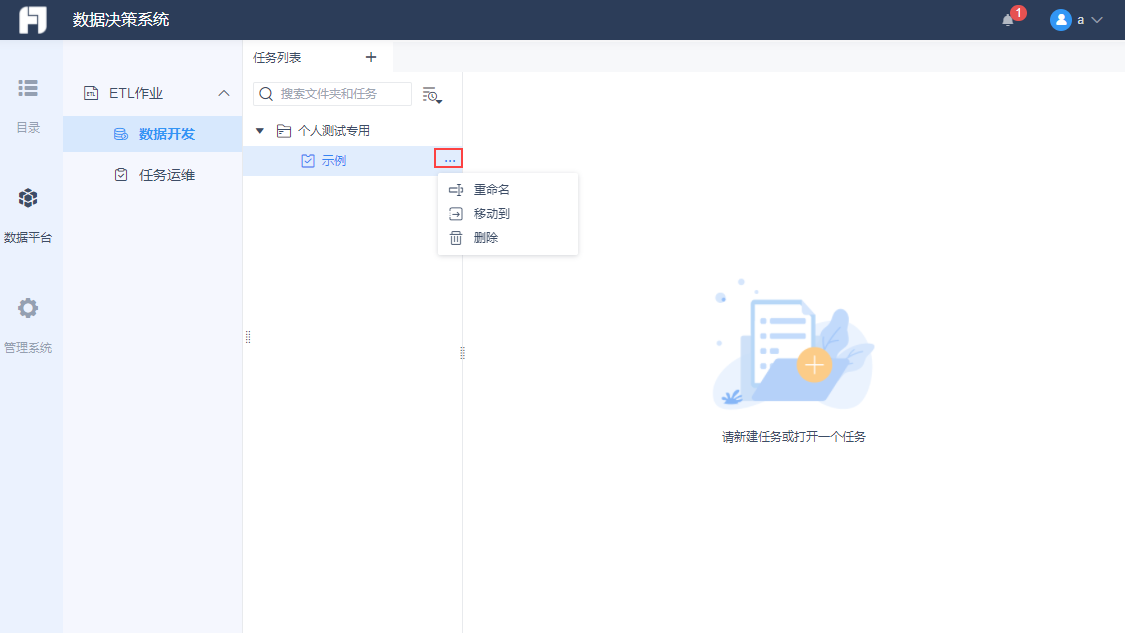

这里创建一个「ETL任务」并命名为「示例」。用户可以对现有的任务或文件夹进行 重命名、移动、删除 等操作。如下图所示:

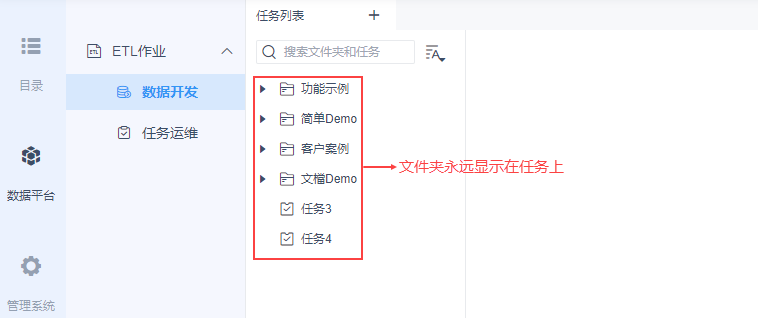

注:插件 1.6 版本对文件夹和任务的显示逻辑进行了优化,现在文件夹和任务分开展示,先展示文件夹,再展示任务。解决文件夹和任务交叉展示,看起来混乱的问题。

2)设计任务

点击「示例」进入任务设计页面,如下图所示:

在此任务中,我们即将实现将一个数据库中的数据迁移到另外一个数据库中,并对迁移过去的数据进行汇总处理。

首先我们在目标数据库中创建两张表,方便之后存放数据。

拖入「SQL脚本」节点,如下图所示:

双击进入「SQL脚本」的编辑界面,输入语句创建两个新表:adb_detail_tabled、adb_summary_table,如下图所示:

- adb_detail_tabled:用于存放从来源数据库中抽取过来的数据

- adb_summary_table:用于存放进行按天聚合处理后的数据

对该节点重命名,命名为「创建目标表」,如下图所示:

创建新表之后,我们就可以将另一个数据库中的数据抽取放到刚刚建的新表 adb_detail_tabled 中。

拖入一个「离线同步」节点,双击进入离线同步的编辑界面。如下图所示:

如何配置「数据来源」「数据去向」,详细请参见:离线同步 2.2节

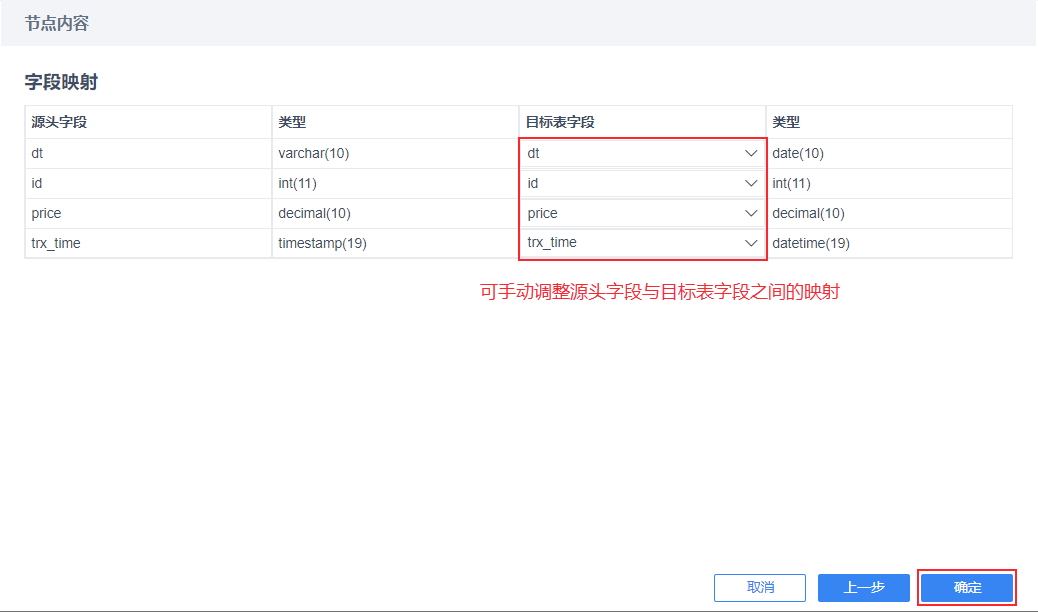

点击「下一步」,系统会自动将取出来的数据与 adb_detail_tabled 中的字段做映射,如下图所示:

若字段与字段之间的映射不正确,用户可以进行手动调整。

如此便可将抽取过来的数据存放到创建的adb_detail_tabled 表中,我们将该节点重命名为「跨库迁移数据」

2数据已经跨库迁移进我们的目标数据库中。我们可以再通过 SQL 语句,对数据进行在处理。

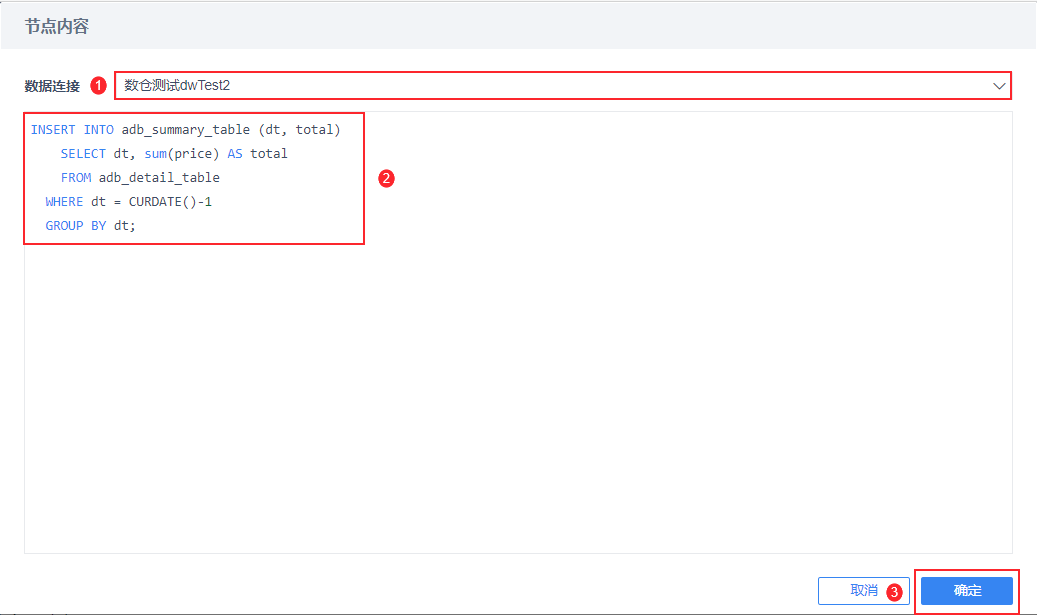

这里我们对原始数据进行按天汇总 price ,然后将处理得到的数据存放到我们 2.2.1 节新建的另一张表adb_summary_table中。

拖入一个新的「SQL脚本」节点,并对其进行编辑,如下图所示:

将该节点重命名为「按天分组汇总」。

我们执行这三个节点的步骤是「创建目标表」>「跨库迁移数据」>「按天分组汇总」,按照这个顺序,我们用连线将这些节点串起来,如下图所示:

设置完所有节点后,在右上角点击「保存」。

3)运行任务

用户有三种运行方式:运行节点、运行节点及下游、保存并运行。其中「运行节点」和「运行节点及下游」需要右击该节点,如下图所示:

- 运行节点:只运行用户选择的某个节点

- 运行节点及下游:运行用户选择的某个节点及其下游的所有节点

- 保存并运行:运行整个任务(即运行所有节点)

更多FineReport数据分析操作欢迎下载体验:点击下载个人免费数据分析可视化软件