- 综合知识导航

- 数据仓库略谈

- 智能制造定义及实现智能制造的意义

- 开源分布式数据库Hbase

- 数据库与大数据数据仓库区别

- MATLAB数据可视化

- 数据仓库简史及特点

- 浅谈如何在前端实现数据可视化热力图

- 18个数据可视化在生活中的应用

- 一文看懂:24种图表数据可视化的优缺点对比

- 10个数据可视化例子,让你更懂可视化

- 经典面试题:说说ETL的过程

- 15个惊艳业界的数据可视化作业案例

- 18篇最好看的数据可视化作品赏析

- 来了解一下数据可视化平台FineBl

- 数据可视化的过程有哪四个

- excel数据可视化图表制作

- 信息可视化设计用什么软件?一个工具,帮你实现酷炫的数据可视化

- FineBI——免费的数据可视化工具软件

- 帆软:做好企业发展的“导航”!

- 大数据数据仓库—概念

- 12个惊艳的数据可视化优秀案例

- 有趣好看的数据可视化图表怎么制作?

- R语言数据可视化分析怎么做

- 数据仓库管理系统与全链路数据体系

- 详解数据数据仓库有哪五层架构

- 数据统计可视化报表设计形式

- 商业智能软件市场 帆软何以独占鳌头?

- 大数据时代下的大数据舆情监测与分析

- 八大数据分析模型一览

- 数据可视化的工具有哪些

- 简述面向航空公司IT的“QAR数据分析系统”

- 数据仓库建模的三种模式

- 数据可视化图表怎么做才对

- 数据仓库的ETL、OLAP和BI应用

- 仓库管理系统选择指南

- 数据可视化需要了解什么

- 优秀的数据可视化怎么做的

- 五个数据分析可视化案例讲解

- 大数据可视化分析有哪四个步骤

- 如何利用插件制作Excel数据可视化图表

- 详解数据仓库搭建步骤

- 基于Hadoop的数据分析平台搭建

- 话说数据仓库分层4层模型

- Excel也有很强大的数据分析工具!

- 数据仓库概念及概述

- 数据挖掘实际案例——想上大学的有哪些人

- 优质数据分析报告的13个要点

- 来说数据仓库建模

- Python数据分析是干嘛的,需要哪些步骤?

- 闲说数据仓库理论上的范式

- 一文罗列数据集市和数据仓库的区别

- 数据分析之数据加工

- ELT数仓技术

- hive和hbase的区别有哪些

- 搭建hive运行环境详解

- 略讲数仓

- 大数据分析中,有哪些常用的大数据分析模型?

- 大数据分析中,有哪些常用的大数据分析模型?

- 数据分析技能

- 如何用R Markdown生成R语言数据分析报告

- 一文读懂基于大数据的数据仓库建设!

- 数据仓库发展趋势(1996-)

- 数据仓库的来源和发展

- 细讲ods数据仓库

- druid kylin 对比

- 数据仓库怎么建立需求?

- 听说过数据库,那数据仓库是做什么的

- 细说数据仓库与数据库的区别

- 开源数据仓库解决方案GreenPlum

- 如何构建数据仓库,本文细讲

- ETL处理流程与技术架构

- 数据治理ETL解决方案

- 数据仓库的多维数据模型设计

- olap与数据仓库的关系及区别

- SQL etl的数据指纹

- 数据仓库 数据湖的区别

- ETL是做什么?学习后有什么用?本文这就告诉你!

- 数据中台 数据仓库的区别

- 数据仓库的分层,你知道吗?

- 谈谈数仓etl系统建设

数据分析之数据加工

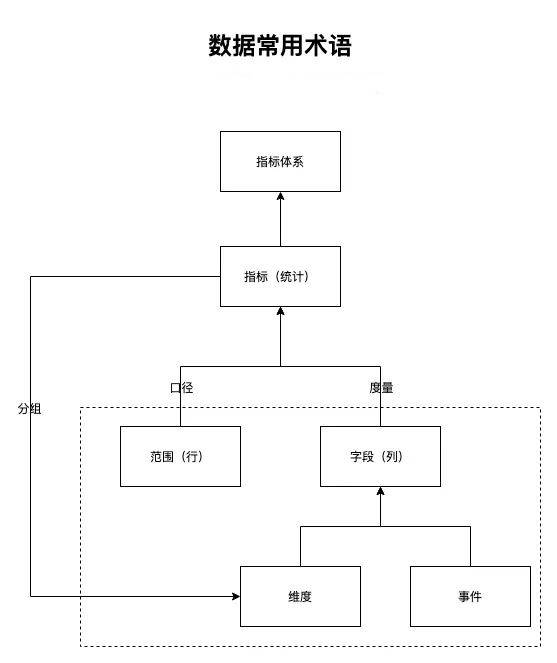

数据加工,根据分析目标和分析模型,提取指标,确定口径,结合已经准备好的数据的特点、逻辑,进行加工统计,并选择适合的分析模型,套用已经清洗好的数据,很方便地就能跑出模型结果。

当然,在实际工作中,确实有不少分析是描述型、简单统计意义上的了解,不需要使用模型。

数据清洗

数据清洗也可称ETL,对结构化的数据进行处理清洗。参考本公众号的文章《一个故事知道ETL是什么》,更好理解。清洗后的数据用起来就很舒服丝滑,不会总是被数据不干净打断进程。主要从以下几个方面进行数据清洗:

不同阶段的业务形态和逻辑,给予新标识或统一逻辑。

构造新字段(列),中间过渡的字段、新增维度字段等。

重新赋值转义字段,按统一标准修改。

异常值、缺失值,根据需要进行填充替换或不处理。

维度和事件,分辨清晰,方便统计。

维度,通常指对象、状态等,数据会变化,事件发生后,事件发生时间前后的值会变化。分析时,就是各种查看的视角、对比的组别。

事件,发生的事情,数据不会再变化(当然有些是bug造成的数据,会修复变更),具有时序性。

指标统计

根据维度和事件,进行度量计算,生成指标。有加减乘除平方等,有计数、去重计数,有最大、最小、第几,有方差、标准差等度量方式,看到这会发现与Excel数据透视表中的计算类似——Excel没有去重计数要变通实现。对于新手来说,这样类比理解是很赞的方式。

哪些数据可以参与计算、采用什么度量方式、先计算什么再计算什么,这就涉及统计口径,是指标另一构成要素。DAU、GMV、AVC、LTV、CPM等,都是常用指标,你知道怎么实现吗?

指标由口径和度量构成,其组合方式极多(维度爆炸),造成指标极多,干扰分析。所以,在分析目标环节要理清出恰当的指标来支持分析。

特殊的维度,对指标进行分组(也叫分桶),比如某天用户打开首页的频次,值域分布1-n,通常就会增加一个分组字段,1次、2次、3-5次、5-10次、10次以上,这就构成了一个新的维度。

下图助于理解,理解了你就是真正的数据分析师了

模型实现

经典模型,R或Python都有实现好的工具包,学院派使用Matlab、SPSS、SAS等收费工具很便捷。有些模型用sql也能实现,但不建议,比较麻烦,况且R或Python也能方便地执行sql。

根据模型的输入项要求,从数据清洗(维度和事件)和指标统计(维度、指标)的结果选择字段(列),限制数据的维度(时间、地域、状态、对象等)范围(行)。

选择合适的模型可以让分析事半功倍。分析模型众多,怎么选呢?关注后续系列哦。

判断修正

根据统计指标和模型结果,结合分析目标环节给到的参考值,分析师进行初步判断,数据加工的结果偏差如何,是否支持分析,是否要修正。

若要修正,这个局面还是不想看到的。但有时,真是会推倒重来,在于前面的分析目标没做到位。除了数据本身的质量问题,还有分析师还不够成熟,对业务不够熟悉、对数据不够敏感,分析目标需求时出现了偏差。

修正虽然不想看到,但也不可怕。从分析目标需求开始,再走一遍。效率会比第一遍高,数据准备、数据加工都有很多复用,不是完全从零开始。

评论区(0)